Über das Projekt

ZERTIFIZIERTE KI

Das wirtschaftliche Potenzial von KI-Technologien ist groß: neue technische Anwendungen, digitale Businessmodelle und praktische Erleichterungen in Alltag und Beruf. Dabei übernehmen KI-Systeme immer komplexere Aufgaben und Entscheidungen, arbeiten mit sensiblen Daten und agieren zunehmend autonom. Die Qualitäts- und Sicherheitsanforderungen an die Technologien sind, insbesondere in Europa, entsprechend hoch. Die Entscheidungen der intelligenten Systeme müssen ethisch vertretbar und technisch nachvollziehbar sein, ihre Methoden zuverlässig und sicher.

Hohe Qualitätsanforderungen an KI-Systeme

In jüngerer Vergangenheit sind viele wichtige Leitplanken und Rahmenbedingungen für den Einsatz von KI-Systemen formuliert worden. So hat die Europäische Kommission den weltweit ersten Regulierungsentwurf (»AI Act«) zum Einsatz von KI-Systemen vorgelegt. Die Normungsroadmap KI zeigt wichtige Bedarfe und Anwendungsfälle für KI-Qualitätsstandards auf. Gleichzeitig sind sich Politik, Wirtschaft und Gesellschaft jedoch einig, dass die teilweise noch abstrakten Anforderungen an vertrauenswürdige KI konkretisiert und operativ umsetzbar gemacht werden müssen.

Die Herausforderung: Qualitätskriterien für eine KI-Anwendung hängen stark vom Anwendungskontext ab, die entsprechenden Maßnahmen variieren je nach verwendeter KI-Technologie. So sind bei einer automatisierten Analyse von Bewerbungsdokumenten die Anforderungen anders als bei einem Bilderkennungsverfahren zur Schadenserkennung auf Autokarosserien. Es werden praxistaugliche Verfahren benötigt, mit denen Unternehmen verschiedenster Branchen arbeiten und sich u. a. auf das Inkrafttreten des AI Acts vorbereiten können.

Praxistaugliche KI-Prüfungen »made in Germany«

All diese Anforderungen an KI-Systeme führt das interdisziplinäre Projektteam aus Wissenschaftler*innen der Bereiche Informatik, Recht und Philosophie sowie zahlreiche Unternehmen verschiedener Branchen zusammen. In Anwenderkreisen definieren die Beteiligten konkrete Anforderungen an KI-Prüfungen, legen Kriterien und Maßstäbe für eine praxistaugliche Prüfung fest und führen Pilotprüfungen durch.

Das gemeinsame Projektziel: Künstliche Intelligenz mit europäischen Qualitätsstandards sicher und vertrauenswürdig gestalten.

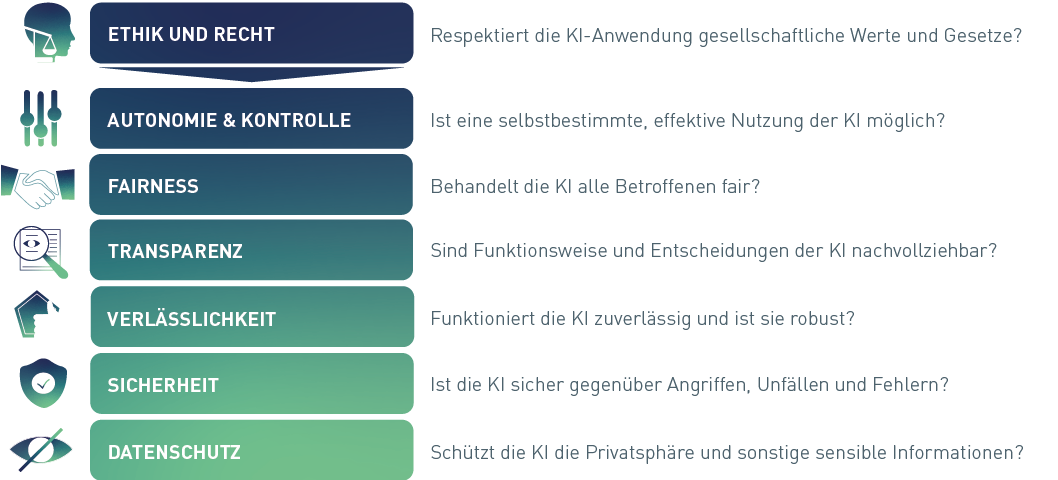

Dimensionen zur Beurteilung der Qualität und Vertrauenswürdigkeit Künstlicher Intelligenz

Als Grundlage für die Zertifizierung von KI-Systemen wurden in interdisziplinärer Zusammenarbeit sieben Dimensionen der Vertrauenswürdigkeit identifiziert und bereits 2020 in einem Whitepaper veröffentlicht.

Handlungsfelder

Die fünf Handlungsfelder bieten eine detaillierte Übersicht über einzelne Projektbausteine und die Zusammenarbeit der Partner.

Prüfgrundlagen

Ziel: Qualitätskriterien für vergleichbare Prüfungen

Angesichts der Vielzahl an Technologien und möglicher Anwendungskontexte wird im Projekt zunächst ein Prüf-Framework für KI-Anwendungen erarbeitet. Die besondere Herausforderung besteht dabei darin, Aussagekraft und Vergleichbarkeit der Prüfungen sicherzustellen. Dafür wird beispielsweise ein einheitliches Vorgehen zur Spezifikation eines KI-Prüfobjektes entwickelt. KI-Risiken sollen durch quantitative Anforderungen messbar, überprüfbar sowie systematisch identifizierbar gemacht werden.

Daraus ergeben sich diverse Aufgabenstellungen wie beispielsweise:

- Welche Aussage kann bzw. soll durch die Prüfung verschiedener Scopes und Tiefen über ein KI-System überhaupt getroffen werden?

- Auf Basis welcher Bewertungsgrundlagen soll daraufhin objektiv entschieden werden, ob die avisierte Prüfaussage tatsächlich bestätigt wird?

- Und welche Rolle spielen die Betreibenden von KI-Anwendungen in dieser Prüfung?

- Sollen organisationsbezogene Fragestellungen bzw. Anforderungen in eine KI-Prüfung einfließen?

Darüber hinaus wird ein sinnvolles Vorgehen entwickelt, um KI-Prüfungen an bereits bestehende Prüfprozesse anzuschließen und weiterzuentwickeln. Dies beinhaltet auch die Einbindung und Transformation von bestehender Prüfinfrastruktur und deren Werkzeuge.

Federführend ist in diesem Handlungsfeld das Bundesamt für Sicherheit in der Informationstechnik (BSI) und wird vom Fraunhofer IAIS durch technologische Analysen wissenschaftlich beraten und unterstützt.

Das Digital Responsibility and Innovation Lab am Institut für Technologie- und Innovationsmanagement der RWTH Aachen University (RWTH TIM) erforscht im Projekt die spezifischen Bedürfnisse zukünftiger Anwender*innen und Verbraucher*innen, sowie die Wirkungsweise und wirtschaftliche Tragfähigkeit einer KI-Zertifizierung.

Primärer Forschungsschwerpunkt ist zunächst die Strukturierung und Quantifizierung des Bedarfs an KI-Prüf- und -Zertifizierungsdienstleistungen für unterschiedliche Anwendungsfelder. Im Anschluss werden die Wirkungen von KI-Zertifizierungen auf Anwender*innen und Verbraucher*innen quantifiziert.

Parallel dazu werden Geschäftsmodelle und Vertriebskonzepte für die Verwertung und Verstetigung von KI-Zertifizierungen entwickelt. Hierbei ermöglicht unser langjähriges Domänenwissen eine möglichst ganzheitliche Bearbeitung. Unser Team besteht aus Wirtschaftswissenschaftler*innen, Psycholog*innen, Ingenieur*innen und Wirtschaftsinformatiker*innen verschiedener Spezialisierungen in den Bereichen der Privatsphäre, Cyber Security, Künstlicher Intelligenz und IT-Adaption.

Unsere breite Expertise im Bereich von Geschäftsmodellinnovationen sowie des strategischen, verhaltensbasierten und computergestützten Technologie- und Innovationsmanagements fließt dabei in die Projektarbeit mit ein. Qualitative Forschungsmethoden werden dafür ebenso genutzt wie experimentelle und statistische Verfahren.

Bedarfsanalyse

Ziel: Untersuchung des wirtschaftlichen Potenzials von KI-Zertifizierungen, Entwicklung von Geschäftsmodellen

Anwenderkreise

Ziel: Beteiligung von Wirtschaft, Industrie und Verbänden

Das DIN ist zusammen mit dem Fraunhofer IAIS für die Organisation der Anwenderkreise aus Wirtschaft, Industrie und Verbänden zuständig. In größtenteils öffentlich zugänglichen Workshops werden industriespezifische Bedürfnisse und die grundsätzliche Marktfähigkeit von KI-Zertifizierungsansätzen diskutiert.

Das Ziel ist schlussendlich die Überführung von Projektergebnissen in Standards und Normen. Bisher haben die Anwenderkreise »Vertrauenswürdige KI-Cloud-Services« und »Transparenz in neuronalen Netzen« ihre Arbeit aufgenommen – nach Bedarf werden weitere gebildet.

Unter Leitung des Informatiklehrstuhls der Universität Bonn entsteht in Zusammenarbeit mit dem Fraunhofer IAIS ein Prüfökosystem für KI-Systeme. Dabei sollen zum einen prototypische Werkzeuge entwickelt werden, mit denen die wesentlichen Eigenschaften eines Machine-Learning-Modells untersucht werden können. Auch die zugehörigen relevanten Daten, die zum Training, Testen oder im Betrieb verwendet werden, müssen entsprechend prüfbar sein.

Zum anderen soll ein Prüflabor konzeptioniert, eingerichtet und öffentlich zugänglich gemacht werden. Dieses soll seinen Anwender*innen ausgewählte Prototypen-Werkzeuge zur Prüfung der eigenen Modelle und Daten zur Verfügung stellen. Zur Illustration dieser Prüfansätze werden Demonstratoren auf Basis einzelner Werkzeuge und Beispielanwendungen entwickelt und auf einer Prüfplattform veröffentlicht.

Mit dieser Kombination aus Plattform, Prüflabor und den verfügbaren Werkzeugen soll der Grundstein für die Entwicklung eines umfassenden Prüfökosystem gelegt werden.

Prüfökosystem

Ziel: Demonstratoren für Prüfwerkzeuge und Konzeption von Prüflaboren

Gesellschaftlicher Diskurs

Ziel: Berücksichtigung von rechtlichen, ethischen und gesellschaftlichen Aspekten

Neben den technischen Fragestellungen werden in dem Projekt nicht zuletzt auch die Rahmenbedingungen von rechtlichen, ethischen und gesellschaftlichen Aspekten und deren Herausforderungen im Rahmen einer KI-Zertifizierung erarbeitet.

Der Philosophie-Lehrstuhl (Center for Science and Thought) der Universität Bonn entwickelt Kataloge mit ethischen Mindestanforderungen für den vertrauenswürdigen und ethischen Einsatz von KI. Basierend auf den bereits in einem Whitepaper definierten sechs Dimensionen Autonomie und Kontrolle, Fairness, Transparenz, Verlässlichkeit, Sicherheit und Datenschutz, wird eine Kategorisierung von Use Cases nach ethisch relevanten Parametern vorgenommen. Diese bilden die Grundlage für die Erarbeitung ethischer und philosophischer Mindestanforderungen für KI‐Anwendungen. Für jeden sozialen Kontext werden diese nun spezifisch zusammengestellt, der zuvor durch die Use Case‐Analyse identifiziert wurde.

In enger Zusammenarbeit mit der Rechtswissenschaftlichen Fakultät der Universität Köln und dem Fraunhofer IAIS werden zudem rechtliche Bewertungsmaßstäbe für KI-Systeme, die im Rahmen einer KI-Zertifizierung nutzbar gemacht werden können, erarbeitet.

Durch gezielte Recherchen werden praxisrelevante Use Cases aus verschiedenen Bereichen ermittelt, in rechtlich operable Anwendungskontexte eingeordnet und hinsichtlich betroffener Rechtsgüter und der gesellschaftlichen und individuellen Ziele analysiert. Der so gewonnene Überblick dient als Grundlage für die Erarbeitung eines Kataloges branchen- und technologieübergeordneter rechtlicher Vorgaben für KI-Systeme. Dabei geht es in erster Linie um die generelle Entwicklung rechtlicher Mindestanforderungen für die jeweilige spezifische Einsatzart.

Die verschiedenen Anwendungskontexte werden anschließend auf ihre speziellen juristischen Fragestellungen hin untersucht, um für einzelne Anwendungsfelder jeweils eigene Kataloge mit spezifischen rechtlichen Mindestanforderungen zu entwickeln.

Kommunikation und Vernetzung

Die Fortschritte und Ergebnisse des Verbundprojektes werden über verschiedene Kommunikationsmaßnahmen veröffentlicht: Neben der Projekt-Webseite werden die Projekt-Informationen bei regelmäßigen Veranstaltungen und in relevanten Social-Media-Kanälen der breiten Öffentlichkeit, Wirtschaft und Politik zugänglich gemacht. Ein interdisziplinärer Austausch von Stakeholdern und Interessierten wird u. a. in den Workshops der Anwenderkreise gefördert.

Sie haben Interesse an einem Austausch oder sonstige Fragen? Kommen Sie gerne auf uns zu!

Weitere Projektinformationen

Stimmen zum Projekt ZERTIFIZIERTE KI

»Eine unabhängige KI-Zertifizierung stärkt das Vertrauen in moderne IT-Technologie und wird auch international als wichtiger Wettbewerbsvorteil erkannt. Mit der Entwicklung marktfähiger Prüfverfahren nähern wir uns dem Ziel mit großen Schritten. Dieses wichtige Projekt mit starken Partnern aus NRW zeigt die große Innovationskraft, die zur Etablierung der Marke ‚KI made in Germany‘ beiträgt.«

Prof. Dr. Andreas Pinkwart, Minister für Wirtschaft, Innovation, Digitalisierung und Energie des Landes Nordrhein-Westfalen

Lesen Sie hier das gesamte Zitat sowie weitere Stimmen zum Projekt.

Projektpartner und assoziierte Partner

Für eine praxisorientierte Entwicklung von KI-Prüfverfahren sind an dem Projekt auch eine große Anzahl an DAX-Konzernen und weiteren Unternehmen als assoziierte Partner beteiligt. Die Einflüsse aus unterschiedlichen Branchen wie Telekommunikation, Finanzwesen, Versicherungen oder Chemie sollen die Entwicklung von relevanten Prüfverfahren unterstützen, um möglichst allgemeingültige Standards zu entwickeln.

Auch Sie haben Interesse am Projekt mitzuwirken? Dann werden Sie ebenfalls assoziierter Partner! Wir freuen uns über Ihre Nachricht.